第06章 卷积神经网络 课堂互动 显示答案 | 返回首页

作者:欧新宇(Xinyu OU)

当前版本:Release v2.0

最后更新:2024-06-10

【课前自测06】

1. 深度神经网络在处理图像时,由于参数数量庞大,可能导致计算资源不足的问题。( )

2. 以下哪些网络模型与卷积神经网络的发展密切相关?

A. LeNet-5

B. AlexNet

C. VGGNet

D. RNN

3. 卷积神经网络中的全连接层主要用于提取图像的特征。( )

4. LeNet是第一个成功应用卷积神经网络解决大规模图像识别问题的模型。( )

5. 以下哪个结构是卷积神经网络CNN的最主要的结构组合?

A. 全连接层-激活层-池化层

B. 卷积层-激活层-池化层

C. 池化层-激活层

D. 卷积层-激活层-全连接层

6. 卷积神经网络中的激活函数层是可选的,不影响网络的性能。( )

7.(多选)在卷积神经网络中,卷积核的主要作用包括( )。

A. 提取图像特征

B. 减小数据维度

C. 增大数据维度

D. 保持数据的空间结构

8. 在卷积和池化的应用下,卷积神经网络的特征图的尺度会随着层次的加深而逐渐变小。若想保持特征图的尺度始终不变,可以采用以下哪种技术?

A. 设置步长参数Stride

B. 设置填充参数Padding

C. 调整池化的类型(max|avg)

D. 调整卷积核的尺度filter_size

9. 设特征图的尺度为48×48×32,若卷积核的尺度为1×1×32,步长stride=1,填充padding=0,则该层需要进行( )次卷积运算。

A. 32

B. 48×48×32=73728

C. 48×48=2304

D. 1×1=1

【课堂互动6.1】卷积神经网络概述@6.1.1 深度神经网络存在的问题

1. 传统深度前馈神经网络(DNN或MLP)无法被广泛应用,其最主要的原因是:( )

A. 神经网络节点过多,导致计算复杂性太高

B. 由于参数过多,容易导致欠拟合问题

C. 无法直接处理高维度的样本,例如基于时间序列音频数据

D. 在处理大数据时,需要人为提取原始数据的特征作为输入,这个尺度很难掌握。

2. 若存在一幅 300×400 的彩色图像,且其后的隐层神经元数量与输入层相同,那么,在输入层和第一层之间的参数个数为:( )。

A. 300 × 400 = 120000

B. 300 × 400 × 3 = 360000

C. 300 × 400 × 300 × 400 = 1.44 ×

D. 300 × 400 × 3 × 300 × 400 × 3 = 1.296 ×

3.(多选)以下属于卷积神经网络的典型特性的包括( )。

A. 平移不变性

B. 光照不变性

C. 色彩不变性

D. 尺度不变性

4. 以下图像的变换,哪些变换可以依赖于尺度不变性实现对图像样本的识别( )。

A. 调整图像的色彩,使其主要对象从红色变为蓝色

B. 将原始图像进行水平反转

C. 将原始图像旋转120度

D. 直接对图像进行大小缩放

5. 为了能实现更好的特征表达能力,除了卷积和池化,卷积神经网络还需要( )。

A. 更宽的网络支持

B. 更深的网络

C. 更多的神经元

D. 更大的卷积核

【课堂互动6.2】卷积神经网络概述@6.1.2 卷积神经网络的历史

1. 以下模型更适合于处理时间序列的一个是:( )。

A. 多层感知机

B. 支持向量机

C. 卷积神经网络

D. 贝叶斯模型

2. (多选)感知机是早期最成功的神经网络,但也存在一些问题,主要包括哪两个?

A. 处理不了线性不可分问题

B. 处理不了线性可分问题

C. 输入特征需要人工选择

D. 权重特征无法自动更新

3. 感受野第一次被提出是在下列哪个时期?

A. 1962年, Hubel和Wiesel对猫大脑视觉系统进行了研究

B. 1975年,日本科学家福岛邦彦提出认知机

C. 1989年,Yann Lecun提出用于手写字体识别的卷积神经网络LeNet-5

D. 2012年,Jeffrey Hinton和Alex Krizhvsky提出卷积神经网络AlexNet

4. (多选)以下应用可以用卷积神经网络来实现的有哪些?

A. 为一幅自然风景画添加梵高的抽象艺术模式

B. 为视频和图像添加字幕信息

C. 从海量的卫星图片中寻找鲸鱼经常出没的位置

D. 在自动驾驶中为汽车找到没有障碍物的道路

E. 从10万张狗的图片中找到混入其中的1幅猫的图片

5. 对于图像分类问题,( )模型预期表现最好?

A. 感知机或多层感知机

B. 支持向量机

C. 卷积神经网络

D. 循环神经网络

【课堂互动6.3】整体框架@6.2

1. 在卷积神经网络中,激活层的主要功能是( )。

A. 增加模型的非线性特性,从而提高模型的拟合能力,

B. 提高模型的训练速度

C. 增强模型的泛化能力

D. 以上都正确

2. (多选)在卷积神经网络中,我们依然会在网络的最后部分增加1-2个全连接层,其主要目的是( )。

A. 进一步减少参数的数量

B. 打破卷积特征的空间限制,从而减少位置固化对分类带来的定势思维的影响。

C. 提高模型对全局信息的获取能力,使所有的元素对最后的分类都具有贡献。

D. 加速模型的训练速度

3. 在卷积神经网络中,通常在每个卷积层背后都会紧跟一个( )。

A. 池化层

B. 全连连接层

C. 激活函数

D. Softmax分类层

4. 输入层作为神经网络的起点,通常使用( )的形式进行输入。

A. 元组

B. 列表

C. 张量

D. 关系型数据

5. 为了方便获得分类结果,经常会在CNN的末尾添加一个全连接层,并且让全连接层的神经元数量等于该任务的类别数。( )

6. 卷积神经网络中的全连接层在结构上是完全连接的,即前一层的每个神经元都与后一层的每个神经元相连。( )

【课堂互动6.4】卷积的基本原理@6.3.1 卷积的动机、卷积运算及图像的卷积

1. (多选)卷积神经网络依靠卷积运算来生成特征图,它使卷积神经网络具有( )的特性。

A. 局部感知

B. 对象定位

C. 权重共享

D. 前景对象显著性

2. (多选)以下对于局部感知描述正确的项包括( )。

A. 卷积操作只关注局部像素,但神经元与采样特征图所有的像素均相连。

B. 卷积操作只关注局部像素,神经元只与采样特征图局部区域的像素相连。

C. 局部连接保证了卷积核对局部特征的最强响应

D. 在同一层中,应用于不同特征图的卷积核的参数固定不变

E. 在同一层中,应用于不同特征图的卷积核具有不同的参数

3. (多选)以下对于权重共享描述正确的项包括( )。

A. 权重共享只发生于同一通道,不同通道之间的权重不共享。

B. 权重共享发生于所有通道,不同通道之间的权重也是相同的。

C. 卷积核在划过整个图像时,每次划动都调整卷积核内部的参数。

D. 卷积核在划过整个图像时,每次划动卷积核的参数都是固定不变的。

4. 与全连接层不同,卷积层保持了样本的空间结构,在进行输入的时候不需要将样本转换为向量形式。( )

5. 若某层及其下一层的特征图维度均为 60×60×10,卷积核的维度为3×3×10,则该层的参数个数为( )(忽略偏置项)。

A. 36000

B. 90

C. 36000×90

D. 36000×36000

E. 90×90

7. 在卷积神经网络的低层中,由于卷积核的尺度远小于输入样本(例如输入图像维度为1024×768×3,而卷积核维度为5×5×3,因此无法完全覆盖整个输入样本,这将会导致对样本特征提取时的信息损失。( )

【课堂互动6.5】卷积的基本原理@6.3.2 图像的卷积

1. 一般来说,一个卷积层只能学到一种特征。所以,如果想要学习图像多种不同的模式,就需要多个卷积层才能实现。( )

2. 在卷积神经网络中,对于第L层,若特征图的数量为n,则该层上的卷积核的个数为:( )。

A. L

B. n

C.

D. 无法确定

3. (多选)卷积和池化运算使得特征图的尺度逐渐变小,这意味着( )。

A. 层数越高,学到的特征就越具有全局化,高层语言越明显

B. 层数越高,学到的特征就越局部化,局部特征越明显

C. 层数越低,学到的特征就越具有全局化,高层语言越明显

D. 层数越低,学到的特征就越局部化,局部特征越明显

4. (多选)卷积核的个数等于( )。

A. 本层特征图的深度

B. 下一层特征图的深度

C. 下一层卷积层卷积核的深度

D. 下一层卷积核的个数

5. (多选)卷积层的计算复杂度与下列哪些超参数有关?

A. 卷积特征图的高度

B. 卷积核的高度

C. 卷积核的深度

D. 卷积核的个数

【课堂互动6.6】填充和步幅@6.4

1. 设输入图像的维度为32×32×3,若存在1个尺度为5×5的卷积核,其步长stride=2,则卷积运算之后的特征图的深度为( )。

A. 1

B. 3

C. 5

D. 32

2. 设特征图的尺度为224×224,若卷积核的尺度为5×5,步长stride=3,则卷积运算之后的特征图尺度为( )。

A. 224

B. 74

C. 219

D. 73

3. 设特征图的尺度为227×227×10,若卷积核的尺度为3×3×10,步长stride=2,填充padding=1,则卷积运算之后的特征图尺度为( )。

A. 227×227×10

B. 224×224×10

C. 114×114×10

D. 113×113×10

4. 设特征图的尺度为32×32×10,若卷积核的尺度为4×4×10,步长stride=2,填充padding=2,则该层的参数个数是多少(忽略偏置项)。

A. 32×32×10×4×4×10=1638400

B. 4×4×10=160

C. (32+2×2-4)/2+1=17

D. ((4+2)×(4+2)+2×2)×10=400

5.(多选)下列有关卷积层说法正确的是( )。

A. 卷积核必须是n×n的形式,即长宽相同

B. 卷积后得到的特征图可以和原图尺寸一致

C. 1×1卷积核常用来做降维,无法对原图提取特征

D. 在卷积层中可以加入激活函数

6. 假设将填充 和 同时增加1倍,则最终的计算时间复杂度会( ),内存占用量会( )。

A. 不变 不变

B. 不变 增加

C. 增加 不变

D. 增加 增加

【课堂互动6.7】多输入通道和多输出通道@6.5

1. 由于灰度图像只有一个颜色通道,因此在使用卷积神经网络对灰度图进行特征提取和建模时,只能使用一个卷积核。( )

2. 灰度图因为只有一个颜色通道,因此一般使用三阶张量进行输入,即(批大小Batch_Size, 高度Height, 宽度Width)。( )

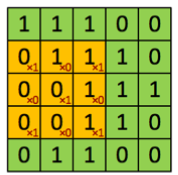

3. 试计算如下特征图和卷积核的计算结果。

A. 2

B. [[0,0,1],[0,0,0],[0,0,1]]

C. 1

D. [[0,1,1],[0,0,1],[0,0,1]]

4. 若对一个分辨率为100×100的RGB图像使用卷积神经网络(卷积核的高宽为3×3)进行特征提取,则第一个卷积层的卷积核的个数是多少?

A. 9

B. 10000

C. 3

D. 无法确定

5. 假设存在一个5×5×4的特征图,如果我们使用一个3×3×4的卷积核对这个特征图进行特征提取(假设padding=0和stride=1),则最终将得到的特征图形态为( )。

A. 3×3×4

B. 3×3×1

C. 5×5×4

D. 5×5×1

6. 假设将输入通道数 和输出通道数 分别增加1倍,则最终的计算时间复杂度会( )。

A. 保持不变

B. 变为原来的2倍

C. 变为原来的4倍

D. 变为原来的8倍

7. 假设存在两个卷积核 和 ,若不存在非线性激活函数,是否可以使用单个卷积核来实现这两个卷积核的功能?( )

【课堂互动6.8】池化层@6.6

1. (多选)以下对池化层描述正确的包括( )。

A. 池化层能够成倍地减少计算量

B. 增加池化层不需要增加参数

C. 池化层可以增加模型非线性特性,从而提高模型的拟合能力

D. 池化层可以为模型增加平移不变性的特性

2. 给定一个3×3的矩阵 A=[[2,2,2],[2,2,2],[2,2,2]],若存在一个 的avg-pooling核,其步长stride=1,则经过池化后的输出结果正确的一项是( )。

A. [[1,1,1],[1,1,1],[1,1,1]]

B. [[2,2],[2,2]]

C. [[1,1],[1,1]]

D. [[1]]

3. 给定一个3×3的矩阵 A=[[1,2,3], [2,3,4], [3,4,5]],若存在一个 的max-pooling核,其步长stride=1,则经过池化后的输出结果正确的一项是( )。

A. [[1,2,3], [2,3,4], [3,4,5]]

B. [[2,3], [3,4]]

C. [[3,4], [4,5]]

D. [[5]]

4. 若存在一个117×117的特征图,后面紧跟一个步长为2,尺度为3×3的池化核。试求经过池化层后,特征图新的维度是多少?

A. 117

B. 114

C. 58

D. 57

5. 观察下图给出的网络拓扑结构图,试计算Conv3在执行均值池化后的特征图的维度。

A. 64

B. 21

C. 2

D. 1

6. 池化层最主要的作用是( )。

A. 压缩图像

B. 提取图像特征

C. 将多维数据一维化

D. 连接卷积层与全连接层

【课堂互动6.9】经典卷积神经网络LeNet@6.7

1. 对于一个卷积神经网络模型,规定它的输入为32×32的RGB,输入张量形状为[16,3,32,32], 这里16表示()。

A. batch_size

B. channel

C. height

D. epoch

2. MNIST是由NIST收集的来自于250个不同人的手写数字数据集,该数据集包含( )个训练集图像。

A. 250

B. 10000

C. 50000

D. 60000

3. 在经典的LeNet-5模型中,总共包含( )个卷积层。

A. 2

B. 3

C. 5

D. 7

4. 在LeNet5模型中,以下哪个层用于实现图像维度的降低?

A. 卷积层

B. 降采样层(池化层)

C. 全连接层

D. 高斯层

【拓展练习06】

1.( )模型是卷积神经网络发展史上的重要里程碑?

A. LeNet-5

B. RNN

C. GAN

D. SVM

2. 卷积操作可以有效地提取图像的局部特征,并获取平移等变性质。( )

3. 池化操作是一种下采样技术,可以减小模型的计算量,并增加平移不变性。( )

4. 卷积神经网络中的卷积核参数对于所有输入位置都是共享的。( )

5. 在卷积神经网络中,( )操作有助于获取图像的尺度不变性?

A. 卷积

B. 池化

C. 激活函数

D. 反向传播

6. 卷积神经网络在逐层叠加的过程中不断进行缩放变换确保了样本尺度不变性,相似的多层感知机的逐层叠加也能够实现尺度不变性。( )

7. 卷积神经网络的"卷积"一词,实际上是一种数学运算方法,该方法属于( )次的运算?

A. 一次

B. 二次

C. 三次

D. 高次

8. 卷积神经网络具有局部连接、权重共享等特性,它已经脱离了前馈神经网络的范畴。( )

9. 图像中识别物体的( )原则体现了模型准确率与目标在图像中的位置无关。

A. 局部性

B. 尺度不变性

C. 独特性

D. 平移不变性

10. 在卷积神经网络中,池化操作的主要作用是( )

A. 增加模型的复杂度

B. 提取图像的局部特征

C. 减小模型的计算量

D. 提高模型的泛化能力

11. 以下( )不是卷积神经网络的特点?

A. 局部连接

B. 权重共享

C. 全连接

D. 层次化特征表示

12. 关于深度神经网络在处理图像时遇到的问题,以下哪些说法是正确的?

A. 每层的神经元个数可能会非常多

B. 全连接网络在处理图像时参数数量巨大

C. 深度神经网络无法处理图像问题

D. 深度神经网络处理图像时需要巨大的计算资源

13. 在图像处理中,目标的局部特性体现在哪些方面?

A. 目标对象可能出现在图像的任何位置

B. 目标的形状和大小可能不同

C. 目标的颜色可能不同

D. 目标的局部区域具有特定的模式

14. 池化操作在卷积神经网络中的作用包括哪些?

A. 减小参数数量

B. 防止过拟合

C. 增加平移不变性

D. 提取图像的局部特征

15. 以下哪些操作是卷积神经网络中常见的?

A. 卷积

B. 池化

C. 全连接

D. 反向传播

16. 哪些因素使得卷积神经网络在处理图像时比全连接网络更有效?

A. 局部连接

B. 权重共享

C. 层次化特征表示

D. 激活函数

17. 对于非结构型的序列化数据,例如简单的二维数据,卷积神经网络并不是特别擅长。( )

18. 在卷积神经网络中,池化层的主要作用是增加特征图的尺寸,以便提取更多的细节信息。( )

19. 卷积神经网络中的卷积核尺寸越大,提取的特征越全局。( )

20. 卷积神经网络中的池化层可以减小特征图的尺寸并减少参数数量。( )

21 卷积神经网络中,卷积层之后通常会接( )层。

A. 全连接层

B. 池化层

C. 卷积层

D. 激活函数层

22. 以下( )不是卷积神经网络相对于全连接网络的优势。

A. 参数数量少

B. 易于训练

C. 易于处理高维数据

D. 难以提取局部特征

23.(多选)在卷积神经网络中,以下哪些层是常见的?( )

A. 卷积层

B. 池化层

C. 全连接层

D. 循环层

24. 卷积运算是卷积层的核心,它对卷积核与特征图执行( ),然后将计算结果按元素进行累加。

A. 外积运算

B. 互相关运算

C. 加和运算

D. 求最大值运算

25. 卷积神经网络中,卷积操作的主要特点是( )。

A. 密集交互

B. 稀疏交互

C. 权重不共享

D. 单一模式学习

26. 卷积操作中,卷积核对( )特性有最强的响应?

A. 全局

B. 局部

C. 边缘

D. 色彩

27. 在卷积神经网络中,卷积核在图像上滑动并执行( )操作?

A. 加法

B. 减法

C. 点乘

D. 除法

28. 假设一个卷积核的尺寸为5x5x3,它适用于哪种尺寸的输入图像?( )

A. 5x5x3

B. 任意尺寸

C. 至少5x5x3

D. 至少32x32x3

29. 在卷积神经网络中,偏置项 通常如何设置?( )

A. 对每个神经元单独设置

B. 对每个卷积核单独设置

C. 对同一层中所有通道的神经元共享

D. 对整个网络共享

30. 卷积神经网络中的参数共享是指( )。

A. 每个神经元都有独立的权重

B. 每个神经元使用相同的权重

C. 同一层的神经元使用不同的权重

D. 不同层的神经元使用相同的权重

31. 在卷积神经网络中,激活特征图是通过( )生成的。

A. 全连接层

B. 卷积操作

C. 池化操作

D. ReLU函数

32. 假设一个卷积层有6个5x5x3的卷积核,那么该层的输出深度是( )。

A. 3

B. 5

C. 6

D. 15

33.(多选)卷积神经网络中,卷积层的主要特点包括( )。

A. 稀疏交互

B. 参数共享

C. 权重不共享

D. 多模式学习

34.(多选)卷积神经网络中,以下( )操作会改变特征图的尺寸。

A. 卷积操作

B. 池化操作

C. ReLU激活函数

D. 全连接操作

35.(多选)卷积神经网络中,以下哪些参数可以通过训练来学习?( )

A. 卷积核的权重

B. 卷积核的尺寸

C. 偏置项

D. 激活函数的类型

36.(多选)激活特征图与以下哪些因素有关?( )

A. 卷积核的数量

B. 卷积核的尺寸

C. 输入图像的尺寸

D. 激活函数的类型

37. 卷积神经网络中的卷积操作是密集交互的。( )

38. 卷积神经网络中的参数共享只发生在同一通道内。( )

39. 卷积神经网络中的每个卷积核都对应一种模式。( )

40. 卷积神经网络中的卷积层输出深度与卷积核的数量相同。( )

41. 卷积神经网络中的全连接层可以处理高维数据。( )

42. 卷积神经网络中的卷积操作会改变输入图像的空间尺寸。( )

43. 卷积神经网络中的偏置项b对同一层中所有通道的神经元都是共享的。( )